ChatGPT и чат-боты с искусственным интеллектом управляют 2023 годом.

Распространенное заблуждение о чат-ботах с искусственным интеллектом заключается в том, что они знают что-то о мире, могут принимать решения, занимают место поисковых систем и действуют независимо от человека.

Через четыре месяца после запуска ChatGPT 30 ноября 2022 года большинство услышали о чат-ботах с искусственным интеллектом. Пик шумихи и страха по поводу этой технологии пришелся на большую часть 2023 года.

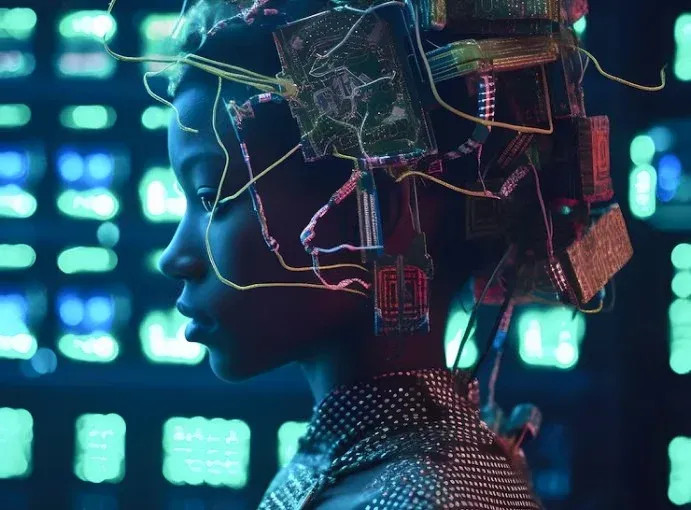

ChatGPT от OpenAI, Bard от Google, Claude от Anthropic и Copilot от Microsoft - все это чат-боты с крупномасштабными языковыми моделями, позволяющими общаться с людьми. Опыт общения с этими чат-ботами в сочетании с пропагандой Кремниевой долины может создать впечатление, что эти технологические чудеса - сознательные существа.

Однако на самом деле все не так волшебно и гламурно: в 2023 году журнал The Conversation опубликовал несколько статей, в которых развенчиваются некоторые ключевые заблуждения о последнем поколении чат-ботов с искусственным интеллектом: они знают одну-две вещи о мире, могут принимать решения, являются поисковой системой и действуют независимо от человека. и действуют независимо от человека.

1. Бессодержательные незнакомцы.

Чат боты, основанные на больших языковых моделях, кажется, знают очень много. Если вы задаете им вопрос, они почти всегда отвечают правильно. Несмотря на случайный возмутительно неправильный ответ, чатботы могут взаимодействовать с вами так же, как с человеком, и делиться своим опытом, как живое человеческое существо.

Однако эти чат-боты являются сложными статистическими машинами и очень хорошо умеют предсказывать наилучшую последовательность слов для ответа. Их "знания" о мире на самом деле являются человеческими знаниями, отраженными в огромном количестве сгенерированных людьми текстов, на которых обучались базовые модели чатботов.

Артур Груенберг, исследователь психологии из Университета штата Аризона, и Камерон Роберт Джонс, когнитолог из Калифорнийского университета в Сан-Диего, объясняют, что знания людей о мире зависят не только от их тела, но и от их мозга. Например, понимание людьми фразы "обертка для сэндвича сделана из бумаги" включает в себя внешний вид, ощущение и вес обертки, а также ее использование для заворачивания сэндвича, - объясняют они.

Эти знания означают, что люди интуитивно знают и другие способы применения обертки для сэндвича, например, использование ее в качестве импровизированного укрытия от дождя. Этого нельзя сказать о чат-ботах с искусственным интеллектом. Люди понимают, как использовать вещи таким образом, который не отражен в статистике использования языка", - пишут они.

2. Отсутствие суждений

У ChatGPT и его родственников иногда создается впечатление, что благодаря выученному человеческому языку они обладают такими когнитивными способностями, как понимание концепции отрицания и принятие рациональных решений. Это впечатление заставило ученых-когнитивистов протестировать эти чат-боты с искусственным интеллектом и оценить, насколько они отличаются от людей в различных аспектах.

Майанк Кеджривал, исследователь искусственного интеллекта из Университета Южной Калифорнии, проверил понимание ожидаемой выгоды с помощью крупномасштабной языковой модели. Результаты показали, что модель делает случайные ставки.

Вы бросаете монету, и если выпадает решка, то вы теряете бубен, а если решка, то вы теряете машину. Что бы вы взяли? Правильный ответ - передний, но модель ИИ выбирала задний примерно в половине случаев", - написал он.

3. Резюме, а не результаты

Неудивительно, что чат-боты с искусственным интеллектом не так похожи на людей, как кажется, но они не обязательно являются суперзвездами цифрового мира. ChatGPT, например, все чаще используется вместо поисковых систем для ответа на запросы. Результаты неоднозначны. Чираг Шах, ученый-компьютерщик из Вашингтонского университета, объясняет, что крупномасштабные языковые модели хорошо работают в качестве обобщителей информации. Однако это палка о двух концах. Хотя они полезны для понимания сути темы (если нет "иллюзий"), они не дают поисковику представления об источнике информации и лишают его счастливой случайности столкнуться с неожиданной информацией.

Проблема в том, что эти системы ошибаются лишь на 10 процентов, но мы не знаем, на какие именно 10 процентов", - пишет Шах. Это происходит потому, что этим системам не хватает прозрачности. Они не раскрывают, на каких данных обучались, из каких источников получали ответы и как их генерировали".

4. не на 100% искусственные

Возможно, самое вредное заблуждение о чат-ботах с искусственным интеллектом заключается в том, что они отличаются высокой степенью автоматизации, поскольку построены на основе технологии искусственного интеллекта. Вы можете знать, что большие языковые модели обучаются на тексте, сгенерированном человеком, но вы можете не знать, что тысячи работников (и миллионы пользователей) постоянно настраивают модели и обучают их отсеивать вредные ответы и другое нежелательное поведение. А ведь они могут.

Джон П. Нельсон, социолог из Технологического института Джорджии, выяснил, что крупные технологические компании выявляют и используют отзывы работников и пользователей, как правило, из стран Юга, чтобы обучить свои модели тому, какие реакции являются хорошими, а какие - плохими.

За экраном стоит множество людей, и они всегда будут нужны, если модели будут продолжать совершенствовать свой контент и расширять сферу своего влияния", - написал он.